MOOC Estimation des incertitudes de mesure en analyse chimique

| Site: | Moodle - Université Claude Bernard Lyon1 |

| Cours: | Estimation des incertitudes de mesure en analyse chimique |

| Livre: | MOOC Estimation des incertitudes de mesure en analyse chimique |

| Imprimé par: | Visiteur anonyme |

| Date: | lundi 9 février 2026, 10:14 |

Table des matières

- 1. Introduction

- 2. Le concept d'incertitude de mesure

- 3. L'origine de l'incertitude de mesure

- 4. Les concepts et outils fondamentaux

- 5. Première quantification de l'incertitude

- 6. Principe de l'estimation de l'incertitude de mesure

- 7. Retour sur les effets aléatoires et systématiques

- 8. Fidélité, justesse, exactitude

- 9. L'approche par modélisation ISO GUM

- 10. Aperçu des approches d'estimation de l'incertitude de mesure

- 11. Approche par validation dite de laboratoire unique

- 12. Comparaison des approches

- 13. Comparaison de résultats de mesure

- 14. Autres ressources

- 15. Autotests

1. Introduction

https://sisu.ut.ee/measurement/uncertainty

Ce cours est un cours d'introduction à l'estimation de l'incertitude de mesure, spécifiquement lié à l'analyse chimique (chimie analytique). Le cours présente les concepts principaux et les outils mathématiques d’estimation de l’incertitude de mesure et présente deux approches principales pour l’estimation de cette incertitude de mesure : l’approche de modélisation ISO GUM (approche «bottom-up» ou approche par modélisation) et l'approche par validation par un seul laboratoire telle que mise en œuvre par Nordtest (approche «top-down» ou Nordtest). Le cours contient des vidéos, des exercices pratiques et de nombreux tests d'auto-évaluation.

http://www.uttv.ee/naita?id=17710

| Hello and welcome to the course estimation of measurement uncertainty in chemical analysis. Chemical analysis is almost ubiquitous in nowadays society. Its high importance ranges from high tech production to environmental protection from health care to food safety. We can say without any exaggeration that each and every one of us is affected by chemical analysis. And chemical analysis actually can also be regarded as chemical measurement. So, the essence of chemical analysis is measuring the content of some compounds in some objects. And every measurement always has an uncertainty meaning the measurement result cannot be regarded as absolutely true, absolutely precise. There's always some imprecision some uncertainty about the measurement result. And this measurement uncertainty is one of the most important quality characteristics of any measurement result consequently also of chemical analysis results. And the estimation of measurement uncertainty in chemical analysis is the topic of this course. | Bonjour et bienvenue dans ce cours sur l'estimation de l'incertitude de mesure en analyse chimique. L'analyse chimique est omniprésente dans notre société. Sa grande place va des technologies de production à la protection de l'environnement en passant par la santé et la sécurité alimentaire. On peut dire sans exagération que chacun d'entre nous est impacté par l'analyse chimique. L'analyse chimique peut aussi être vue comme étant la mesure chimique. Ainsi, l'essence même de l'analyse chimique réside dans la mesure de la quantité de composés dans des objets. Et chaque mesure a toujours une incertitude, ce qui signifie que le résultat de la mesure ne peut pas être considéré comme absolument juste et absolument fidèle. Il y a toujours une certaine imprécision, une certaine incertitude sur le résultat de la mesure. Et cette incertitude de mesure est une des caractéristiques de qualité les plus importantes de tout résultat de mesure et par conséquence de tout résultat d'analyse chimique. L'estimation de l'incertitude de mesure en analyse chimique est le sujet de ce cours. |

Malgré son caractère introductif, ce cours a pour objectif d'apporter suffisamment de connaissances et de compétences pour effectuer une estimation de l’incertitude de la plupart des analyses chimiques courantes en laboratoire. Les exemples et les exercices font référence au titrage acide-base, à la détermination de l'azote de Kjeldahl, à la spectrophotométrie UV-Vis, à la spectroscopie d'absorption atomique et à la spectrométrie de masse couplée à la chromatographie en phase liquide (LC-MS). Il est cependant important de souligner que, pour réussir l'estimation de l'incertitude de mesure, l'expérience (en chimie analytique en tant que telle et en estimation de l'incertitude) est cruciale et que celle-ci ne peut être acquise que par la pratique.

Le contenu de ce cours peut également être utile aux personnes qui n’ont pas l’intention de suivre le cours dans son intégralité mais qui souhaitent uniquement trouver des réponses à certaines questions spécifiques. Ce cours a été décrit dans l'article I. Leito, I. Helm, L. Jalukse. Using MOOCs for teaching analytical chemistry: experience at University of Tartu. Anal. Bioanal. Chem. 2015, DOI: 10.1007/s00216-014-8399-y.

Prérequis

Si une connaissance de base de la chimie analytique est seulement nécessaire, une connaissance plus approfondie de la chimie analytique et une connaissance introductive de la statistique mathématique sont un avantage. L'usage d'un logiciel type tableur (MS Excel, OpenOffice, etc.) est fortement recommandé.

http://www.uttv.ee/naita?id=17711

|

Why is measurement uncertainty important? Why do we need to know how to estimate measurement uncertainty? Let us look at an example and let us look at an example of determination of a pesticide thiabendazole in citrus fruits. And suppose we had two laboratories who have made the analysis. One of those laboratories has obtained the result for a particular lot of some citrus fruits has obtained the result of 4.2 milligrams per kilogram. We have here an axis of concentration and we mark, can mark this 4.2 here on this axis. So now suppose the other laboratory has got somewhat higher result and the result of the other laboratory is 4.7 milligrams per kilogram. What can we see about these results are they in agreement or are they in disagreement? Well at first sight we could say that no well no of course they are in disagreement they are strongly different there's no doubt about that. But reality pesticide determination in food at low levels is a difficult analytical task. And it is very difficult to do it in such a way that the results will be very very accurate. Therefore these results actually have high uncertainties. These uncertainties can be several tens of percent of those values themselves. So that if we put realistic uncertainty estimates on these values, we can see a completely different picture. Let us do that. Both of these measurement results are now characterized by uncertainty of roughly plus minus 0.6 milligrams per kilogram. And we see that actually the value according to this laboratories measurement can be anywhere within this range including here. And the true value according to this laboratories result can be anywhere within this range including here. Therefore, we have actually no reason to say that the results are different. In fact, the results agree very well. So, in order to compare two measurement results, we need to know their uncertainties. Now why do people carry out pesticide determination in food? They carry this analytical determination out because they want to know whether we can eat the food or not. So, in order to say whether this thiabendazole concentration in citrus fruit is okay or not, we need to know the maximum permissible limit or maximum residual limit of thiabendazole and this limit in the European Union is five milligrams per kilogram. So here comes this maximum residual limit, and if we now look at these results, we can see that although the results themselves are below 5 milligrams per kilogram there is also some probability that the true value is above there. Probably the true content of pesticide in the citrus fruit is below 5 milligrams per kilogram but we cannot be completely sure in this and the decision remains with the respective Food Authority as to whether these fruits could still be sold or not. So, we see that measurement uncertainty is first of all an important quality characteristic content measurement result and secondly it also is necessary for comparing results. And this has been recognized by different authorities and in fact nowadays one of the requirements if a laboratory wants to accredit its management system is the ability to be able to estimate measurement uncertainty for the results of chemical analysis and measurements that laboratory makes. So that the measurement uncertainty estimation ability is also required from the laboratories by authorities. |

Pourquoi l'incertitude de mesure est-elle importante ? Pourquoi avons-nous besoin d'estimer l'incertitude d'une mesure ? Regardons un exemple et prenons l'exemple de la détermination d'un pesticide, la thiabendazole dans des citrons. Supposons que nous ayons deux laboratoires qui ont réalisé cette analyse. Un des laboratoires a obtenu un résultat pour un lot de citrons, et a obtenu un résultat de 4,2 milligrammes par kilogramme. Nous avons ici un axe de concentration et nous pouvons placer 4,2 sur cet axe. Maintenant supposons que l'autre laboratoire a obtenu un résultat plus grand et le résultat de cet autre laboratoire est de 4,7 milligramme par kilogramme. Ce que l'on peut voir au sujet de ces résultats : sont-ils en accord ? Ou sont-ils en désaccord ? Au premier coup d'œil nous pouvons dire que bien sûr ils sont en désaccord, ils sont très différents, il n'y a aucun doute là-dessus. Mais en réalité, la détermination des pesticides dans la nourriture à très faible niveau est une analyse très difficile. Et il sera très difficile de le faire de telle sorte que les résultats soient extrêmement exacts. Ainsi, ces résultats sont actuellement assortis d'une grande incertitude. Cette incertitude peut représenter plusieurs dizaines de pourcents de ces valeurs. Et si nous plaçons des valeurs réalistes de l'incertitude sur ces valeurs, nous pouvons avoir une image complètement différente. Faisons le… Les deux résultats de mesure sont maintenant caractérisés par une incertitude de plus ou moins 0,6 milligrammes par kilogramme. Nous voyons maintenant que la valeur attribuée à cette mesure par le laboratoire peut se situer n'importe où dans cette plage, même ici. Et la valeur vraie selon les résultats de ce laboratoire peut être n'importe où dans cette plage, même ici. Ainsi, nous n'avons aucune raison pour dire que ces résultats sont différents. En fait, les résultats sont en très bon accord. Donc pour comparer deux résultats de mesure, nous avons besoin de connaitre leurs incertitudes. Pourquoi les gens recherchent-ils des pesticides dans l'alimentation ? Ils réalisent cette mesure analytique parce qu'ils veulent savoir si nous pouvons manger ces aliments ou pas. Pour dire si cette concentration en thiabendazole dans les citrons est satisfaisante ou pas, nous avons besoin de connaitre la limite maximale autorisée ou limite maximale résiduelle de thiabendazole, et cette limite dans l'Union Européenne est de 5 milligrammes par kilogramme. Apparaît maintenant cette limite maximale résiduelle, et si nous regardons maintenant ces résultats nous pouvons voir que si les résultats sont inférieurs à 5 milligrammes par kilogramme, il existe une certaine probabilité que la valeur vraie soit au-dessus. Probablement, la valeur vraie en pesticide dans les citrons est inférieure à 5 milligrammes par kilogramme mais nous ne pouvons en être totalement certains. La décision incombe à l'autorité de surveillance de l'alimentation de décider si ces fruits peuvent être vendus ou pas. Ainsi, l'incertitude d'une mesure est tout d'abord une caractéristique importante de la qualité du résultat de mesure et d'autre part, elle est nécessaire pour comparer des résultats. Ceci a été reconnu par différentes autorités et, en fait maintenant, une des exigences pour un laboratoire qui souhaite accréditer son système de management réside dans sa capacité à estimer les incertitudes de mesure pour les résultats d'analyse chimique et les mesures qui sont réalisées par le laboratoire. Ainsi l'aptitude à estimer l'incertitude de mesure est demandée aux laboratoires par les autorités. |

2. Le concept d'incertitude de mesure

https://sisu.ut.ee/measurement/introduction-concept-measurement-uncertainty

Résumé : Cette section présente les concepts de mesurande, valeur vraie, valeur mesurée, erreur, incertitude de mesure et probabilité.

http://www.uttv.ee/naita?id=17583

|

Let us see now what measurement uncertainty is and then let us see this on an example of a glass of water. Water is the most important liquid in our lives we all drink a lot of water and it is very important that drinking water is healthy, and one part of its healthiness comes from the content of minerals. There are always some small amounts of salts in this water. Many of those salts are even somewhat good for our health but some however are toxic. And if we speak about toxic minerals or toxic salts, we first of all speak about different metal cations. And let us examine the toxic metal lead. There's always some small amount of lead in drinking water but as long as it's small enough it's not really harmful for our health. But it's important that the small level it does not get too high and therefore it’s important to make chemical analysis of water to determine whether it is suitable for drinking or not. So, our measurement in this case is lead content in water and we denote it by C, and we measure it in micrograms per liter. This concentration can assume different values therefore we have here an axis concentration axes and in the in order to make this example more concrete let us also put some real concentration values on this axis. So, this is five, this is six, this is seven micrograms per liter. Now if we again take this glass of water then obviously there's a certain number of lead ions swimming around in this water. Meaning there is some true concentration of lead in this water, and if we were able to count those layered ions, we would know how much they are. Unfortunately, and this is true for almost all analytical chemistry we almost never can really count molecules or atoms meaning the true value will almost always remain unknown for us. And from the point of view of measurement science we can say that the true value is an abstract concept. So even though we are always aiming at the true value with our measurement, we almost never can really achieve it. Let us denote this true value here now. Let's assume it's somewhere here so we call it Ctrue. And according to this scale it's equal to 5.7 micrograms per liter. Now we optimize our measurement procedures in such a way that we would get our measurement result as close to the true value as possible, but we almost never exactly achieve it and we almost never will know if we achieved it or not. So now let us suppose that our measured value in this case happens to be six point one micrograms per litter. Now the difference between the true value and the measured value is called error. And we denote error by Delta, and delta is equal to Cmeasured minus Ctrue. Now, as true value for us is an abstract concept so is also the error because if we would know what the error is then by obviously knowing our measured value, we would be able to calculate the true value, but this is not possible. So unfortunately, people cannot use the concept of error or true value for characterizing the quality of this measured value here. So, what people do instead, they define a range around this measured value and they define this range in such a way that the true value would be within this range with high probability. So, and this range is called uncertainty range. And the half width of this range is called uncertainty. We can be noted by U and in this case the uncertainty is equal to 0.5 micrograms per litter. Now if we have made this measurement and obtained this measurement result and we have made uncertainty estimation taking into account all the uncertainty sources which are influencing the measurement result and we arrived at this uncertainty estimate, we can present our measurement result. And this would look like this. Result, our C is equal 6.1 plus minus 0.5 micrograms per liter. So, instead of trying to give the exact true value or the difference from the true value which we cannot do, we give this range, and this range means that with high probability the true value lies within this range. So, this result tells us to a person that looks at this result that the true value of lead in this water is between 5.6 and 6.6 micrograms per liter. And as we see in this particular case it fully holds because the true value is 5.7 It would be fair to ask why am I speaking about high probability, why don't I say that the true value certainly lies within region? We will see later on that almost never we can present uncertainty in such a way that it embraces the true value with 100% probability. Almost always uncertainty presentation is probabilistic. We will see later on that this way of writing is actually not enough if we want to correctly present measurement result, but that will come later and for the moment this way of presenting the result is for this example sufficient. It is interesting to ask now as we have received this kind of result, can we drink this water or not? Is this level of lead in drinking water in the permissible region or not? The permissible value of lead concentration in drinking water in the European Union is 10 micrograms per liter. We see that 6.1 of course is significantly below 10 but we also must take into account the uncertainty, meaning in principle the true value would also be somewhere higher here. As I said uncertainty range never can have 100 percent probability but it is good to know that probability outside of this range decreases exponentially so that with very high probability the value is within this range, and if we already would go to 5 to 7 range the probability would be extremely high so that the probability of the true content being somewhere above there is very very low. So that this this water is fully suitable for drinking! |

Regardons maintenant ce que représente l'incertitude de mesure. Regardons ceci sur l'exemple d'un verre d'eau. L'eau est le liquide le plus important pour notre vie, nous buvons énormément d'eau et il est très important que cette eau soit saine. Une partie de sa qualité sanitaire provient du fait qu'elle contient des minéraux. Il y a toujours de petites quantités de sel dans l'eau. La plupart de ces sels sont même nécessaires pour notre santé, mais quelquefois ils sont toxiques. Et si nous parlons de minéraux ou de sels toxiques, nous devons parler des différents cations métalliques. Examinons un métal toxique tel que le plomb. Il y a toujours une petite quantité de plomb dans l'eau de boisson, mais pour autant qu'elle soit suffisamment faible, elle n'est pas toxique pour notre santé. Mais il ne faut pas que ce niveau devienne trop important, et donc il est important de réaliser une analyse chimique de l'eau pour déterminer si elle est acceptable comme boisson ou pas. Ainsi, dans ce cas, notre mesure est la quantité en plomb dans l'eau que nous nommerons C et nous le mesurerons en microgramme par litre. Cette concentration peut prendre différentes valeurs donc nous avons ici un axe : l'axe des concentrations, et dans le but de rendre cet exemple plus concret, nous allons positionner la valeur réelle de la concentration sur cet axe. Nous avons ainsi cinq, six et sept microgrammes par litre. Maintenant, si nous prenons ce verre d'eau il y a évidemment un certain nombre d'ions plomb en suspension dans cette eau. Cela signifie aussi qu'il y a une vraie concentration de plomb dans l'eau et si nous sommes en capacité de compter ces ions, nous pourrions connaitre leur nombre. Malheureusement, et ceci est vrai pour presque toutes les analyses chimiques, nous ne pouvons pas réellement compter les molécules ou atomes, ce qui signifie que la vraie valeur restera quasiment toujours inconnue pour nous. Et du point de vue de la science de la mesure, nous pouvons dire que la valeur vraie est un concept abstrait. Ainsi, même si nous tendons vers la valeur vraie avec nos mesures, nous ne pouvons presque jamais l'atteindre. Plaçons cette valeur vraie. Nous supposerons qu'elle est ici et nous l'appellerons Cvraie (Ctrue). Et sur cette échelle, elle est égale à 5,7 microgrammes par litre. Maintenant, nous optimisons nos procédures de mesure de telle sorte que nous ayons notre résultat de mesure aussi proche que possible de la valeur vraie, mais nous ne pourrons jamais l'atteindre exactement, et nous ne saurons jamais si nous l'atteignons ou pas. Maintenant, supposons que notre valeur mesurée soit égale à 6,1 microgrammes par litre. La différence entre la valeur vraie et la valeur mesurée est appelée erreur. Et nous désignerons cette erreur par Delta et Delta est égal à Cmesurée moins Cvraie. Maintenant, comme la valeur vraie est un concept abstrait, l'erreur l'est aussi parce que si nous connaissions la valeur de l'erreur, alors en connaissant la valeur mesurée, nous serions à même de calculer la valeur vraie. Mais ce n'est pas possible. Malheureusement, on ne pourra pas utiliser le concept d'erreur ou de valeur vraie pour caractériser la qualité de la valeur mesurée ici. Ainsi, ce que les gens font à la place, ils définissent une étendue autour de la valeur mesurée, et ils définissent une étendue de telle sorte que la valeur vraie se trouve dans cette étendue avec une grande probabilité. Ainsi, cette étendue est appelée étendue d'incertitude. La demi-largeur de cette étendue est appelée incertitude. Nous pouvons la noter U et, dans ce cas, l'incertitude est égale à 0,5 microgramme par litre. Si nous avons réalisé cette mesure et obtenu un résultat de mesure, et si nous avons réalisé une estimation de l'incertitude en tenant compte de toutes les sources d'incertitude qui influencent le résultat de la mesure et que nous arrivions à une valeur de l'incertitude, nous pourrons présenter notre résultat de mesure. Et il ressemblera à ceci. Résultat : C est égale à 6,1 0.5 microgramme par litre. Ainsi, plutôt que d'essayer de donner la valeur exacte de la valeur vraie ou la différence entre la valeur vraie ce que nous ne pouvons faire, nous donnons une étendue et cette étendue signifie, qu'avec une grande probabilité, la valeur vraie est dans cette étendue. Ainsi, ce résultat signifie que pour une personne qui regarde ce résultat, que la valeur vraie du plomb dans l'eau est comprise entre 5,6 et 6,6 microgrammes par litre. Et comme nous pouvons le voir dans ce cas particulier ceci est correct car la valeur vraie est 5,7. Il pourrait être normal de demander pourquoi je parle de grande probabilité et pourquoi je ne dis pas que la valeur vraie est certainement comprise dans cette région. Nous verrons plus tard que nous ne pourrons quasiment jamais donner une incertitude de telle sorte qu'elle contienne la valeur vraie avec une probabilité de 100%, Presque toujours, l'expression de l'incertitude est de type probabiliste. Nous verrons plus tard que cette façon d'écrire n'est pas suffisante si nous voulons présenter correctement le résultat de la mesure, mais ceci sera présenté plus tard et pour le moment cette façon de présenter le résultat et suffisant pour cet exemple. Il est intéressant de se demander maintenant que nous avons reçu ce type de résultat, peut-on boire cette eau ou pas ? Est-ce que ce niveau de plomb dans l'eau est admis dans la région ou pas ? La valeur autorisée de la concentration en plomb dans l'eau de boisson de l'Union Européenne est de 10 mg/L. Nous voyons que 6,1 est bien significativement inférieur à 10 mais nous devons tenir compte de l'incertitude, ce qui signifie en principe que la valeur vraie pourrait être plus grande ici. Comme je l'ai dit, l'étendue de l'incertitude ne peut pas avoir une probabilité de 100% mais il faut savoir que la probabilité hors de cette étendue décroit exponentiellement. Et ainsi, avec une très grande probabilité la valeur vraie est à l'intérieur de cette étendue qui va de 5 à 7. Cette probabilité étant très importante, la probabilité que la vraie valeur de la concentration soit quelque part plus grande est très très faible. Ainsi, cette eau est totalement buvable ! |

La mesure est un processus permettant d'obtenir expérimentalement la valeur d'une quantité. La quantité que nous avons l'intention de mesurer s'appelle le mesurande. En chimie, le mesurande est généralement la quantité de matière ou la concentration d'une entité chimique (molécule, élément, ion, etc.) dans un objet. L'entité chimique à déterminer est appelée analyte. Les mesures chimiques peuvent être, par exemple, la concentration de plomb dans un échantillon d’eau, la teneur en pesticide du thiabendazole dans une orange ou la teneur en matière grasse dans une bouteille de lait. Dans l'exemple précédent, le plomb (élément), l'acide ascorbique (molécule) et le tissu adipeux (groupe de molécules différentes) sont les analytes. L'eau, l'orange et le lait sont des objets d'analyse (ou des échantillons prélevés à partir d'objets d'analyse).

En principe, le but d’une mesure est d’obtenir la vraie valeur du mesurande. Tous les efforts sont faits pour optimiser la procédure de mesure (procédure d'analyse chimique ou procédure d'analyse) de manière à ce que la valeur mesurée soit aussi proche que possible de la valeur réelle. Cependant, notre résultat de mesure ne sera qu'une estimation de la valeur réelle et la valeur réelle restera (presque) toujours inconnue de nous. Par conséquent, nous ne pouvons pas savoir exactement à quel point notre valeur mesurée est proche de la valeur réelle - notre estimation comporte toujours une certaine incertitude.

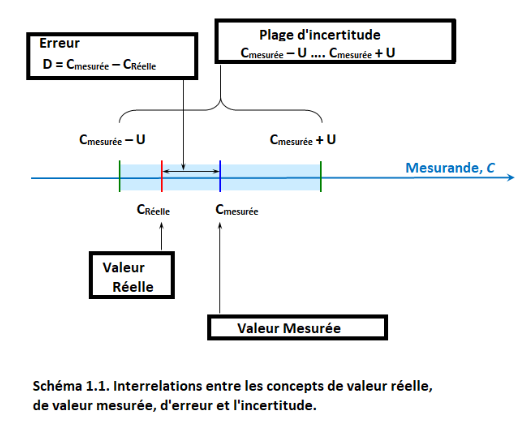

La différence entre la valeur mesurée et la valeur vraie est appelée erreur. Une erreur peut avoir un signe positif ou négatif. L’erreur peut être considérée comme composée de deux parties - l’erreur aléatoire et l’erreur systématique - qui seront traitées plus en détail dans les prochains chapitres. Comme la valeur vraie, l'erreur nous est inconnue. Par conséquent, elle ne peut pas être utilisée dans la pratique pour caractériser la qualité de notre résultat de mesure, son accord avec la valeur réelle.

La qualité du résultat de mesure est caractérisée par l’incertitude de mesure (ou simplement l’incertitude), qui définit un intervalle autour de la valeur mesurée CMEASURED, où la valeur vraie CTRUE se situe avec une certaine probabilité. L'incertitude de mesure U elle-même est la demi-largeur de cet intervalle et est toujours non négative. Le schéma suivant (similaire à celui de la vidéo) illustre ceci :

L’incertitude de mesure est toujours associée à une probabilité - comme on le verra dans les prochains chapitres, il n’est généralement pas possible de définir l’intervalle d’incertitude de telle sorte que la valeur réelle y soit comprise avec une probabilité de 100%.

L'incertitude de mesure, telle qu'exprimée ici, s'appelle dans un contexte également l'incertitude de mesure absolue. Cela signifie que l'incertitude de mesure est exprimée dans les mêmes unités que le mesurande. Comme nous le verrons dans les cours suivants, il est parfois plus utile d’exprimer l’incertitude de mesure sous la forme d’une incertitude relative de mesure, qui est le rapport entre l’incertitude absolue Uabs et la valeur mesurée y :

(1.1)

(1.1)

L'incertitude relative est une quantité sans unité, qui est parfois exprimée en pourcentage.

L’incertitude de mesure est différente de l’erreur en ce sens qu’elle n’exprime pas de différence entre deux valeurs et qu’elle n’a pas de signe. Par conséquent, ell ne peut pas être utilisée pour corriger le résultat de la mesure et ne peut pas être considérée comme une estimation de l'erreur car celle-ci a un signe. Au lieu de cela, l’incertitude de mesure peut être considérée comme notre estimation de la différence absolue la plus probable entre la valeur mesurée et la valeur réelle. Avec une probabilité élevée, la différence entre la valeur mesurée et la valeur réelle est en fait inférieure à l'incertitude de mesure. Cependant, il existe une faible probabilité que cette différence puisse être supérieure à l'incertitude de mesure.

Autoévaluation sur cette partie du cours : Test 1

3. L'origine de l'incertitude de mesure

https://sisu.ut.ee/measurement/origin-measurement-uncertainty

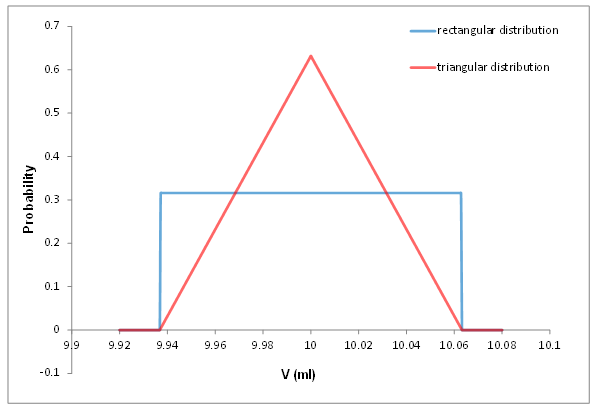

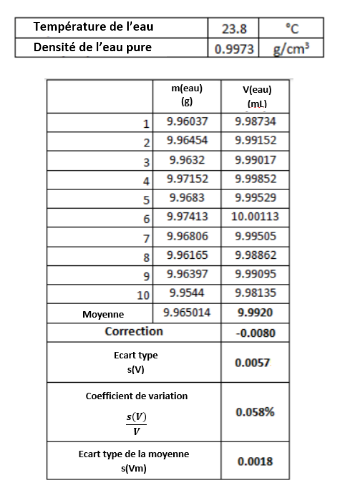

Résumé : Présentation, sur l'exemple du pipetage, de l'origine de l'incertitude de mesure. Le concept de sources d'incertitude (effets provoquant un écart de la valeur mesurée par rapport à la valeur réelle) est présenté. Les principales sources d’incertitude liées au pipetage sont introduites et expliquées : répétabilité, étalonnage, effet de la température. Une explication des effets aléatoires et systématiques est donnée. Le concept de répétabilité est introduit.

La première vidéo montre comment le pipetage avec une pipette volumétrique classique est réalisé et explique d'où provient l'incertitude du volume pipeté.

Pourquoi les résultats de mesure présentent-ils une incertitude ? Le concept de source d'incertitude expliqué sur l'exemple du pipetage

http://www.uttv.ee/naita?id=17577

| Let us see now where measurement uncertainty comes from, and let us see that on the example of pipetting. So I am holding in my hand a 10 milliliter volumetric pipet and I'm going to pipet now with this pipette exactly 10 milliliters of water from this water beaker into this sample beaker. And suppose we need this water for some kind of chemical analysis and we need that in the sample beaker we really have 10 milliliters. And I'm going to conduct this pipetting now and then I'm going to explain what are the possible uncertainty sources that come into play when we do pipetting. So the pipette is a clean pipette, but even in the case of a clean pipette it is a good idea to first rince it a couple of times with the solution that we are going to pipette. So, we fill the pipette. It is not important at the moment to fill it exactly to the mark Instead we deliberately overfill and we empty it into the waste beaker. It is important to say that rinsing with the solution that you are going to pipette, which is water in our case, is much more useful than rinsing with pure water. Actually rinsing with pure water cannot be recommended because if the solution itself is not pure water, then that rinsing will possibly dilute your solution which eventually you will be pipeting. So I'm now rinsing two times not taking special care to fill it to any special level and now I'm going to fill it to exactly 10 milliliters. Again I'm filling the pipette and I'm going to first overfill a little bit. And then the remaining water, I will drain into the same waste beaker and now it is important that I keep the mark exactly at the height of my eyes and that I keep the pipette really vertical. All right. And now, I drain the remaining water into the sample beaker and again it is important to keep the pipette vertically. And also, as you can see, I'm holding the pipette tip against the wall of the beaker. And, after all the liquid has been pipeted, I wait for five seconds before removing the pipette. So keeping the pipette tip against the beaker wall is very important because there's always some small amount the water that remains in the volumetric pipet and it should remain there. But some water still comes from the walls and it will be each time aspirated into the beaker the same way if you keep the pipette tip against the beaker wall not in the air. Alternatively you can also keep the pipette tip against the solution surface. So now as we've done this pipeting, the sample beaker now contains as close as we can volume to ten milliliters of water, and let us think now where uncertainty comes from. There are several uncertainty sources that are inherent in pipetting, the first of them is that even though I took every care to fulfill the pipette really to the mark exactly always I either slightly overfill or slightly underfill the pipette. Secondly the mark itself even though it is supposed to be exactly 10 milliliters but this mark position also has an uncertainty which actually is also stated on the pipette. It's plus minus 0.03 milliliters in this particular case. Then the third uncertainty component is the uncertainty due to the temperature effect. Temperature affects both pipette volume and water density. The volume of glassware is not very sensitive towards temperaturen but the volume of liquid is. And therefore if the temperature is above or below the temperature at which the pipette was calibrated, we get respectively less or more water molecules in our beaker. And almost all glassware always is calibrated at 20 degrees centigrade which also is the case of this particular pipette as it can be seen it reads 20 degrees centigrade. These three uncertainties always need to be taken into account when we look at uncertainty of volumetric measurement, but there can be other uncertainty sources which sometimes can be of importance. Almost all these volumetric glassware are calibrated using water, therefore they are meant to deliver liquid that really is very much like water meaning either water or dilute solution. Whenever you pipette oil or some very viscous solution, maybe some high density solution, then the pipetted volume can differ and then it's a good idea to pipette, to calibrate the pipette himself or herself. And finally if the pipette is not clean then there can remain droplets of water on pipette walls after pipetting which means that the volume delivered is not anymore the same as we need. As we see in this our case there are no water droplets so this uncertainty source in our case does not come into play. | Regardons maintenant d'où vient l'incertitude de mesure, et regardons cela au travers de l'exemple du pipetage. Je tiens dans ma main une pipette de 10 millilitres et je vais maintenant pipeter avec cette pipette exactement 10 millilitres d'eau, depuis ce bécher d'eau vers le bécher échantillon (sample). Supposons que nous ayons besoin de cette eau pour une analyse chimique, et que nous ayons besoin d'avoir dans le bécher échantillon réellement 10 millilitres d'eau. Je vais maintenant réaliser le pipetage et j'expliquerai quelles sont les sources possibles d'incertitude qui sont impliquées lorsque nous pipetons. Cette pipette est une pipette propre, mais même avec une pipette propre, c'est une bonne idée de tout d'abord la rincer une paire de fois avec la solution que nous allons ensuite pipeter. On remplit donc la pipette. Il n'est pas important pour le moment de la remplir jusqu'au trait. En fait, nous remplissons au-delà du trait et nous la vidons dans le bécher poubelle. Il est important de préciser que rincer avec la solution que l'on doit prélever, qui est de l'eau dans notre cas, est beaucoup plus utile que rincer avec de l'eau pure. Dans ce cas, rincer avec de l'eau pure n'est pas recommandé parce que la solution à analyser n'est pas de l'eau pure. Et ce rinçage à l'eau pure pourrait diluer la solution que vous voulez pipeter. Je rince maintenant deux fois sans précaution spécifique pour remplir à un niveau particulier, et je vais maintenant remplir pour avoir exactement 10 millitres. Je remplis la pipette et je vais tout d'abord la remplir au-delà du trait. Concernant l'excès d'eau, je vais le verser dans le même bécher poubelle. Maintenant il est important que je mette le trait exactement au niveau de mes yeux et que je garde la pipette parfaitement verticale. Voilà. Je verse l'eau dans le bécher échantillon et à nouveau il est important de garder la pipette verticale. Et aussi, comme vous pouvez voir, je positionne la pointe de la pipette contre la paroi du bécher (NDT angle de 45°). Et, après que le liquide ait été pipeté, j'attends 5 secondes avant de retirer la pipette. Garder la pointe de la pipette contre la paroi du bécher est très important car il y a toujours une petite quantité d'eau qui reste dans la pipette, et qui doit rester. Mais un peu d'eau vient encore des parois et elle sera aspirée chaque fois dans le bécher de la même manière si vous gardez l'embout de la pipette contre la paroi du bécher et non dans l'air. Vous pouvez aussi garder l'embout de la pipette contre la surface de la solution. Maintenant que nous avons fait ce pipetage, le bécher d'échantillon contient aussi près que possible un volume de dix millilitres d'eau. Réfléchissons maintenant d'où vient l'incertitude. Il y a plusieurs sources d'incertitude inhérentes au pipetage. La première d'entre elles est que même si j'ai pris le plus grand soin pour remplir la pipette exactement au trait de jauge, je remplis toujours légèrement trop ou légèrement moins la pipette. Deuxièmement, le trait de jauge lui-même, même si il est censé être exactement à 10 millilitres, cette position du trait a aussi une incertitude qui est également indiquée sur la pipette. C'est plus moins 0,03 millilitre dans ce cas particulier. Enfin, la troisième composante d'incertitude est l'incertitude due à l'effet de la température. La température affecte à la fois le volume de la pipette et la densité de l'eau. Le volume de la verrerie n'est pas très sensible à la température mais le volume du liquide l'est. Et donc, si la température est supérieure ou inférieure à la température à laquelle la pipette a été calibrée, nous obtenons respectivement moins ou plus de molécules d'eau dans notre bécher. Presque toute la verrerie est calibrée à 20 degrés Celsius, ce qui est également le cas de cette pipette en particulier, comme on peut le voir, il est indiqué 20 degrés Celsius. Ces trois incertitudes doivent toujours être prises en compte lorsque nous examinons l'incertitude de la mesure volumétrique, mais il peut y avoir d'autres sources d'incertitude qui peuvent parfois être importantes. Presque toutes ces verreries volumétriques sont calibrées à l'eau, donc elles sont destinées à délivrer un liquide qui ressemble beaucoup à de l'eau, c'est-à-dire de l'eau ou une solution diluée. Chaque fois que vous pipetez de l'huile ou une solution très visqueuse, peut-être une solution à haute densité, alors le volume pipeté peut différer et c'est une bonne idée pour pipeter, de calibrer la pipette soi-même. Enfin, si la pipette n'est pas propre, il peut rester des gouttelettes d'eau sur les parois de la pipette après pipetage, ce qui signifie que le volume délivré n'est plus le même, comme nous en avons besoin. Comme nous le voyons dans ce cas-ci, il n'y a pas de gouttelettes d'eau, cette source d'incertitude dans notre cas n'entre pas en ligne de compte. |

La deuxième vidéo montre le pipetage avec une pipette automatique moderne et explique les sources d'incertitude associées au pipetage avec une pipette automatique.

Source d'incertitude de mesure du pipetage avec une pipette automatique

http://www.uttv.ee/naita?id=18164

| Let us see now where measurement uncertainty comes from if we do pipetting with an automatic pipette. I'm holding in my hand an automatic pipette and with despite that I'm going to pipette now exactly 2,3 milliliters of water from this water beaker into this sample beaker. Let us first examine this pipette a little bit it is a pipette with adjustable volume and the volume can be adjusted from 500 to 5000 microliters meaning from 0.5 to 5 milliliters. And with this knob, I can set the volume here and what I have done now I have exactly said 2,3 milliliters yet what I need to pipette. Before pipetting I need to attach to the pipette, a pipette tip. So and now the pipette is ready for use. Pipetting with an automatic pipette is in several ways different from pipetting with the glass pipette, but some things are similar also. First of all, also with the automatic pipette is useful to rinse before pipetting. But here the rinsing is not so much about cleaning the pipette tip because the tip as they come from such containers or from packages are usually very carefully clean. But rinsing the tip as I will show you in a minute serves the purpose of saturating the gas phase above the liquid with the liquid vapors which is important for pipetting accurate volume. Pipetting with an automatic pipette is done using this knob and it has two stops. One stop and the second stop. If I push it to the first stop then exactly the right volume of the liquid is delivered but the second stop is meant for emptying the pipette completely. So that before taking the liquid into the pipette, I pushed to the first stop and release and when I deliver the liquid I push to the second stop and release. And let's see now how this works. I first rinse the pipette two times and then I will pipette the liquid volume of 2,3 milliliters into this sample beaker. So the pipette is held vertically, and the liquid is aspirated into the pipette slowly. Okay. And now I release it into the waste beaker. And now I push to the second stop. Again I push to the first stop immerse, take the liquid slowly. Okay, And now slowly push to the second stop and I touch with pipette tip either the beaker wall or the liquid itself. And now as I rinse two times I now take the third time the liquid, and I deliver it into the sample beaker. And again I dispense completely and touch with the top of the pipette the liquid. So this beaker now should contain exactly 2,3 milliliters of water and it's important to see now that the pipette tip has to be completely clean of any liquid droplets. This means that all the liquid has been dispensed into that beaker. Let us see now where the uncertainty comes from if we do pipetting with such an automatic pipette. Pipetting with the automatic pipette on one hand looks easier than pipetting with the glass pipette. But in fact it's more tricky and there are more uncertainty sources involved. First of all, again, we have the calibration uncertainty as we had with the glass pipette and this is the calibration accuracy component of this pipette. And it can be said that with with large volume automatic pipettes it usually is significantly higher than with glass pipette but with smaller ones it can be smaller. And secondly it's very important that if a glass pipette is calibrated then it keeps its calibration for very long time almost infinitely. But these pipettes needs occasional recalibration because the mechanics little bit changes with time inside here. And so the calibration can drift away and this drift can be maybe up to 1% of the volume which is quite quite a lot. Secondly an important uncertainty component is the speed of pushing and releasing this button. It has to be as uniform as possible and it's very good if the person who uses it also calibrates it with the same kind of speed. Then the third important uncertainty sources is rinsing and vapor saturation with aqueous solutions. This is not so critical, and in fact in simpler applications people often do pipetting without any rinsing at all. But if you pipette something which is more volatile then such rinsing is absolutely must, otherwise you can get maybe 10 or 15% lower volume than otherwise you should. As with glass pipettes, it is important with automatic pipettes that a liquid which is pipetted is similar to the one with which the pipette was calibrated. As long as we pipette dilute aqueous solutions all is fine. But if the pipette is calibrated with water as is usually the case, and if the solution that then is pipetted is some concentrated salt solution or may be concentrated alkali or acid then again quite significant additional uncertainty can come. And it can come largely because of the density difference of the liquids and the density difference will cause less liquid to be held in this pipette because some slight vacuum will form here so that part of the liquid will fall out before you can take the pipette out of the liquid. Then the temperature effect of course has the same influence here as in the glass pipette but again here it's more tricky. If the pipette is kept in hand for a long time then the temperature of this mechanical part increases and it can be significantly warmer than the temperature in the room. So that in fact the temperature effect with this type of pipette can be larger. There are also some other uncertainty sources that rather refer to sloppy working practices. One of them is using an incorrect tip. The next one is using a tip but not attaching it properly. And then, also if pipetting isn't done either under an angle, this also introduces additional uncertainty. True, in certain applications, for people it is much more easy to pipette at an angle than vertically, and in such a case people oftentimes calibrate the pipette also under angle then it's okay. |

Voyons maintenant d'où vient l'incertitude de mesure si nous pipetons avec une pipette automatique. Je tiens dans ma main une pipette automatique et, avec cela, je vais pipeter exactement 2,3 millilitres d'eau de ce bécher d'eau dans ce bécher à échantillon. Examinons d'abord un peu cette pipette, c'est une pipette à volume réglable et le volume peut être ajusté de 500 à 5000 microlitres soit de 0,5 à 5 millilitres. Et avec ce bouton, je peux régler le volume ici, et c'est ce que je fait maintenant, j'ai exactement dit 2,3 millilitres, c'est ce que j'ai besoin de pipeter. Avant de pipeter, je dois fixer à la pipette un embout de pipette. La pipette est maintenant prête à l'emploi. Le pipetage à l'aide d'une pipette automatique diffère de plusieurs façons du pipetage à la pipette en verre, mais certaines choses se ressemblent aussi. Tout d'abord, avec une pipette automatique, il est également utile de rincer avant le pipetage. Mais ici le rinçage ne consiste pas tant à nettoyer l'embout de la pipette, car l'embout provenant de ces boites ou de leurs emballages a été généralement très soigneusement nettoyé. Mais le rinçage de l'embout, comme je vais vous le montrer dans une minute, sert à saturer la phase gazeuse au-dessus du liquide avec les vapeurs liquides, ce qui est important pour pipeter un volume exact. Le pipetage avec une pipette automatique se fait à l'aide de ce bouton qui a deux butées. Un premier arrêt et un deuxième arrêt. Si je pousse le bouton jusqu'à la première butée, le volume exact du liquide est délivré, et la deuxième butée est destinée à vider complètement la pipette. Ainsi, avant d'introduire le liquide dans la pipette, j'ai poussé jusqu'à la première butée et je l'ai relâché, et lorsque je délivre le liquide, j'ai poussé jusqu'à la deuxième butée et relâché. Et voyons maintenant comment ça marche. Je rince d'abord la pipette deux fois, puis je pipette un volume de liquide de 2,3 millilitres dans ce bécher à échantillon. Ainsi, la pipette est maintenue verticalement et le liquide est aspiré lentement dans la pipette. D'accord. Et maintenant, je le jette dans le bécher à déchets. Et maintenant, je pousse jusqu'au deuxième arrêt. Encore une fois, je pousse jusqu'au premier arrêt, immerge, et prend le liquide lentement. Ok, et maintenant, je pousse doucement jusqu'à la deuxième butée et je touche avec la pointe de la pipette soit la paroi du bécher, soit le liquide lui-même. Et maintenant que j'ai rincé deux fois, je prends la troisième fois le liquide et je le verse dans le bécher d'échantillon. Et encore une fois, je verse complètement et je touche le liquide avec le dessus de la pipette. Ce bécher doit donc maintenant contenir exactement 2,3 millilitres d'eau et il est important de voir maintenant que l'embout de la pipette doit être complètement propre de toute gouttelette de liquide. Cela signifie que tout le liquide a été versé dans ce bécher. Voyons maintenant d'où vient l'incertitude si nous faisons du pipetage avec une telle pipette automatique. Le pipetage avec la pipette automatique d'une part semble plus facile que le pipetage avec la pipette en verre. Mais en fait, c'est plus délicat et il y a plus de sources d'incertitude. Tout d'abord, encore une fois, nous avons l'incertitude d'étalonnage que nous avions avec la pipette en verre et c'est la composante d'exactitude d'étalonnage de cette pipette. Et on peut dire qu'avec les pipettes automatiques de grand volume, elle est généralement beaucoup plus élevée qu'avec les pipettes en verre, mais avec les plus petites, elle peut être plus petite. Et deuxièmement, une fois la pipette en verre calibrée, elle conserve son calibrage pendant très longtemps, presque à l'infini. Or ces pipettes automatiques ont besoin d'un recalibrage occasionnel parce que la mécanique change un peu avec le temps à l'intérieur. Ainsi, l'étalonnage peut dériver et cette dérive peut représenter jusqu'à 1 % du volume, ce qui est assez important. Deuxièmement, un élément important d'incertitude est la vitesse de pression et de relâchement de ce bouton. Elle doit être aussi uniforme que possible. Et c'est très bien si la personne qui l'utilise, l'étalonne aussi avec le même type de vitesse. Ensuite, la troisième incertitude importante provient du rinçage et de la saturation en vapeur des solutions aqueuses. Ceci n'est pas si critique, et en fait, dans les applications les plus simples, les gens font souvent du pipetage sans aucun rinçage. Mais si vous pipetez quelque chose qui est plus volatil, alors un tel rinçage est absolument nécessaire, sinon vous pouvez obtenir peut-être 10 ou 15% de volume en moins que ce que vous devriez obtenir autrement. Comme pour les pipettes en verre, il est important, dans le cas des pipettes automatiques, qu'un liquide qui est pipeté soit similaire à celui avec lequel la pipette a été calibrée. Tant que nous pipetons des solutions aqueuses diluées, tout va bien. Mais si la pipette est calibrée avec de l'eau comme c'est habituellement le cas, et si la solution qui est ensuite pipetée est une solution saline concentrée ou une solution alcaline ou acide concentrée, une incertitude supplémentaire assez importante peut apparaître. Cela peut venir en grande partie de la différence de densité des liquides, et la différence de densité fera que moins de liquide sera retenu dans cette pipette parce qu'un léger vide se formera ici, de sorte qu'une partie du liquide tombera avant que vous puissiez retirer la pipette du liquide. L'effet de la température a bien sûr la même influence que dans la pipette en verre, mais là encore, c'est plus délicat. Si la pipette est tenue en main pendant une longue période, la température de cette pièce mécanique augmente et elle peut être nettement plus chaude que la température ambiante. Ainsi, l'effet de température de ce type de pipette peut être plus important. Il existe également d'autres sources d'incertitude qui font plutôt référence à des pratiques de travail bâclées : l'une d'elle est liée à l'utilisation d'un mauvais embout, la suivante est d'utiliser le bon embout mais de ne pas l'attacher correctement, et puis, si le pipetage est fait avec un angle, cela introduit aussi une incertitude supplémentaire. Il est vrai que, dans certaines applications, il est beaucoup plus facile pour les gens de pipeter sous un certain angle plutôt que verticalement, et dans ce cas, les gens calibrent souvent la pipette aussi sous ce même angle, ce qui est alors correct. |

Les résultats de mesure comportent une incertitude car il existe des sources d’incertitude (effets générateurs d’incertitude). Ce sont des effets qui entraînent des écarts de la valeur mesurée par rapport à la valeur réelle. Si la procédure de mesure utilisée est bien connue, les sources d'incertitude les plus importantes sont généralement également connues. Des efforts devraient être fait pour minimiser et, si possible, éliminer les sources d'incertitude en optimisant la procédure de mesure (procédure d'analyse). Les sources d'incertitude qui ne peuvent pas être éliminées (et il n'est jamais possible d'éliminer toutes les sources d'incertitude) doivent être prise en compte dans l'estimation de l'incertitude.

L'ampleur des déviations causées par des sources d'incertitude est généralement inconnue et, dans de nombreux cas, ne peut pas être connue. Ainsi, ces déviations ne peuvent qu'être estimés. Si nous pouvons estimer l'ampleur de chacune des sources d'incertitude importantes, nous pouvons les combiner et obtenir une estimation de l'incertitude de mesure, qui dans ce cas sera appelée incertitude composée. La façon dont cette combinaison est mathématiquement réalisée sera démontrée dans les prochains chapitres.

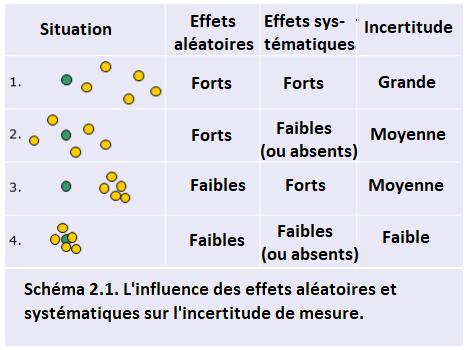

Si nous faisons plusieurs mesures répétées du même mesurande, alors idéalement, toutes ces mesures répétées devraient donner exactement la même valeur et cette valeur devrait être égale à la valeur vraie du mesurande. En réalité, les résultats des mesures répétées diffèrent presque toujours dans une certaine mesure et leur valeur moyenne diffère également de la valeur réelle. Les sources d'incertitude sont la cause. De manière quelque peu simplifiée, les sources d'incertitude (ou effets) peuvent être divisées en effets aléatoires et effets systématiques. Le schéma suivant illustre ceci (les cercles verts indiquent les valeurs vraies, les cercles jaunes les valeurs mesurées):

Les effets aléatoires provoquent une différence entre les résultats répétés de mesure (et donc, bien sûr, aussi avec la valeur vraie). Cependant, si un grand nombre de mesures répétées est effectué, la valeur moyenne sera peu influencée par les effets aléatoires (situation 2 sur le schéma). Ainsi, l’influence des effets aléatoires peut être diminuée en augmentant le nombre de répétitions. Les effets systématiques entraînent une déviation identique de toutes les mesures de la série dans la même direction. L'augmentation du nombre de répétitions ne permet pas de diminuer leur influence (situation 3 sur le schéma).

En principe, il est souhaitable de déterminer l’ampleur et la direction des effets systématiques et de corriger les résultats de mesure pour les effets systématiques. Cependant, cela peut souvent être très difficile et trop exigeant en terme de temps de travail, que cela devient impraticable. Par conséquent, dans de nombreux cas, plutôt que de déterminer exactement les effets systématiques et de les corriger, leur ampleur possible est estimée et est prise en compte comme source d’incertitude. Dans les chapitres 5.4 et 6, les effets aléatoires et systématiques sont traités de manière plus complète.

Il existe en général quatre sources principales d’incertitude dans les mesures volumétriques, à savoir les mesures à l’aide de pipettes, de burettes, de éprouvettes graduées et de fioles jaugées:

- Incertitude due à la répétabilité non idéale de la mesure (souvent appelée incertitude de répétabilité). Dans le cas du pipetage, cela signifie que si nous essayons avec soin de remplir et de vider la pipette, nous obtiendrons néanmoins à chaque fois un volume légèrement différent. Cela est parfois appelé «effet humain» ou «facteur humain», mais en fait, si une machine effectue le pipetage, il y aurait également une différence entre les volumes (bien que probablement plus petite). La répétabilité est un effet aléatoire typique et contribue à l'incertitude avec les pipettes en verre ainsi qu'avec les pipettes automatiques. Son influence sur le résultat de la mesure peut être diminuée en effectuant des mesures répétées, mais elle ne peut jamais être totalement éliminée.

- Incertitude due à l'étalonnage de l'équipement volumétrique (souvent appelée incertitude d'étalonnage). Dans le cas de la verrerie volumétrique, c’est l’incertitude sur la position des marques sur la verrerie volumétrique. Dans le cas des pipettes automatiques, cette incertitude est due au déplacement systématiquement trop élevé ou trop faible du piston à l'intérieur de la pipette. Dans le cas d'une pipette donnée, il s'agit d'une source d'incertitude systématique typique. Cette source d'incertitude peut être considérablement réduite en recalibrant la pipette dans le laboratoire par la personne qui travaille réellement avec elle. Le pesage exact de l’eau à température contrôlée est la base de l’étalonnage des instruments volumétriques, ainsi que la manière dont les incertitudes de répétabilité des différents instruments volumétriques sont généralement trouvées.

- Incertitude due à l'effet de la température (souvent appelée incertitude de la température). Tous les appareils volumétriques sont généralement calibrés à 20°C et les volumes se réfèrent généralement à des volumes à 20°C. La densité du liquide change (presque toujours diminue) avec la température. Si le pipetage est effectué à une température supérieure à 20°C, la quantité de liquide pipetée (en masse ou en nombre de molécules) est plus petite que si elle était effectuée à 20°C. Par conséquent, le volume de cette quantité de liquide à 20°C est également plus petit que si le pipetage était effectué à 20 C. Dans le cas de verreries volumétriques, la température affecte les dimensions de la vaisselle volumétrique (son volume augmente avec la température). Comme l'effet du changement de densité de liquide est environ 10 fois plus important, le changement de volume de la verrerie volumétrique est presque toujours négligé. Dans le cas des pipettes automatiques, l’effet de la température est plus complexe. Si l'air à l'intérieur de la pipette se réchauffe, le volume de liquide distribué peut varier dans une certaine mesure. Si la température du laboratoire et, ce qui est important, la température du liquide à la pipette, est constante pendant les mesures répétées, l'effet de la température est un effet systématique.

- Sources d'incertitude spécifiques à l'application. Celles-ci ne sont pas causées par l'équipement volumétrique, mais par le liquide manipulé ou par le système faisant l'objet de l'enquête. Quelques exemples:

1. Si une solution moussante est pipetée, mesurée au moyen d’une fiole jaugée ou d’une éprouvette graduée, on ne sait pas où se situe exactement la «solution», c’est-à-dire qu’il n’y a pas de ménisque bien défini. Cela provoquera une incertitude supplémentaire. Selon la situation, cet effet peut être aléatoire ou systématique ou inclure une partie aléatoire et une partie systématique.

2. Si le titrage est effectué à l'aide d'un indicateur visuel, le point final du titrage, c'est-à-dire le moment où l'indicateur change de couleur, est supposé correspondre au point d'équivalence (le point de stœchiométrie). Toutefois, en fonction de la réaction de titrage et de l'analyte titré, le résultat final peut être obtenu plus tôt ou plus tard que le point d'équivalence. Dans le cas du titrage donné, il s'agira d'un effet systématique. Cet effet peut être minimisé par un autre moyen de détection de point final, par ex. titrage potentiométrique

Il existe certaines autres sources d'incertitude qui s'avèrent généralement moins importantes, car elles peuvent être minimisées ou éliminées par des pratiques de travail correctes (toutefois, elles pourraient être importantes si ces pratiques n'étaient pas correctement appliquées). Les effets restants affectent généralement la répétabilité du pipetage ou son incertitude d'étalonnage et peuvent être pris en compte dans ces sources d'incertitude.

- Si la pipette n'est pas conservée verticalement (pipettes en verre et automatiques), l'attente n'est pas assez longue après la fin du drainage de la solution (pipette en verre), le volume de la pipette sera alors inférieur à celui obtenu avec un pipetage correct. Aucune attente n'est nécessaire dans le cas des pipettes automatiques car il ne reste pas de film liquide (et ne doit pas rester) sur la pipette jusqu'aux parois internes.

- Lors de l'utilisation d'une pipette en verre, il est toujours possible que de petits résidus de la solution précédente restent dans la pipette. Il est donc judicieux de rincer la pipette avant de pipeter (par exemple deux fois) avec la solution à pipeter (et de la jeter avec la solution de rinçage dans les déchets, pas dans le récipient d'où la solution a été prélevée). Dans le cas des pipettes automatiques, il est judicieux d’utiliser un nouvel embout chaque fois qu’une nouvelle solution est pipetée. Dans ce cas, cette contamination est généralement négligeable. En outre, lorsque vous pipetez plusieurs fois la même solution avec la même pipette, il est judicieux de contrôler l'absence de gouttelettes sur les parois internes et de remplacer la pointe lorsque les gouttelettes apparaissent.

- Si les parois d'une pipette en verre ne sont pas propres, des gouttelettes peuvent rester sur les parois après le drainage de la solution de pipetage. Cela conduit à un volume différent du cas où il ne reste plus de gouttelettes sur les parois de la pipette après avoir drainé la solution. La chose évidente à faire est de nettoyer la pipette.

- Si le liquide pipeté est très différent de l'eau (par exemple, un liquide très visqueux, tel que de l'huile végétale), le volume pipeté peut être systématiquement différent du volume nominal de la pipette. Cet effet existe à la fois avec les pipettes en verre et avec les pipettes automatiques. Dans un tel cas, la pipette doit être recalibrée avec le liquide en question ou la pesée doit être utilisée à la place de la volumétrie

Dans le chapitre 4, les sources d'incertitude du pipetage (la même expérience de pipetage que celle présentée dans la vidéo) seront quantifiées et combinées dans l'estimation de l'incertitude de mesure du volume pipeté. Les chapitres 4.1 à 4.5 présentent le calcul de l'incertitude à l'aide d'une pipette étalonnée en usine. Le chapitre 4.6 présente un exemple de calcul d’incertitude de mesure du volume de pipette à l’aide d’une pipette auto-étalonnée. Le chapitre 5 donne un aperçu de la majorité des sources d'incertitude rencontrées lors d'une analyse chimique.

Autoévaluation sur cette partie du cours : Test 2

4. Les concepts et outils fondamentaux

https://sisu.ut.ee/measurement/distribution-functions-normal-gaussian-distribution

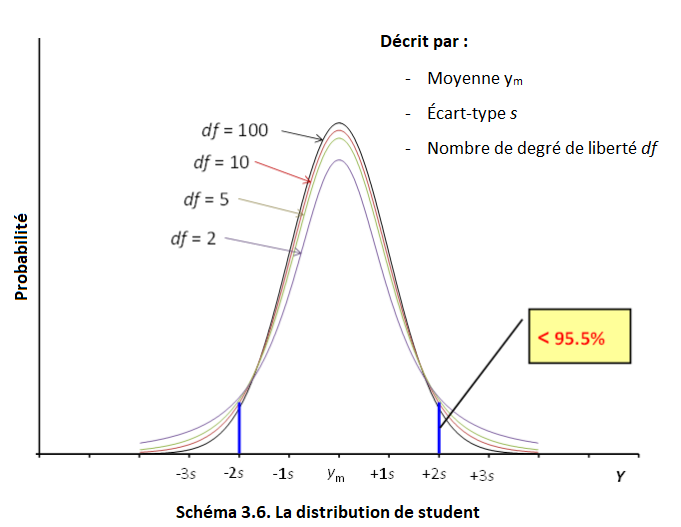

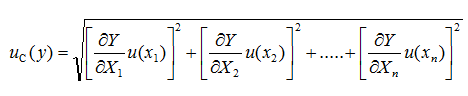

Résumé : Cette section présente les concepts et outils les plus fondamentaux pour une estimation pratique de l’incertitude de mesure. Premièrement, les concepts de quantités aléatoires et de fonctions de distribution sont présentés. Ensuite, la distribution normale - la fonction de distribution la plus importante dans la science de la mesure - est expliquée et ses deux paramètres principaux - la valeur moyenne et l'écart type - sont introduits (3.1). Sur la base de l'écart type, le concept d'incertitude type est introduit (3.1, 3.2). Ensuite, l'estimation de l'incertitude de type A et de type B sont introduites (3.3). La valeur moyenne des quantités aléatoires est également une quantité aléatoire et sa fiabilité peut être décrite par l'écart type de la moyenne (3.4). Outre la distribution normale, trois fonctions de distribution supplémentaires sont introduites: la distribution rectangulaire et triangulaire (3.5) ainsi que la distribution de Student (3.6).

4.1. La fonction normale de distribution

https://sisu.ut.ee/measurement/31-normal-distribution

Résumé : Ce cours commence par généraliser que toutes les valeurs mesurées sont des quantités aléatoires du point de vue de la statistique mathématique. La distribution la plus importante en science de la mesure - la distribution normale - est ensuite expliquée : son importance, les paramètres de la distribution normale (moyenne et écart type). Les définitions initiales d'incertitude type (u), d'incertitude élargie (U) et de facteur d'élargissement (k) sont données. Un lien entre ces concepts et la distribution normale est créé.

La distribution normale

http://www.uttv.ee/naita?id=17589

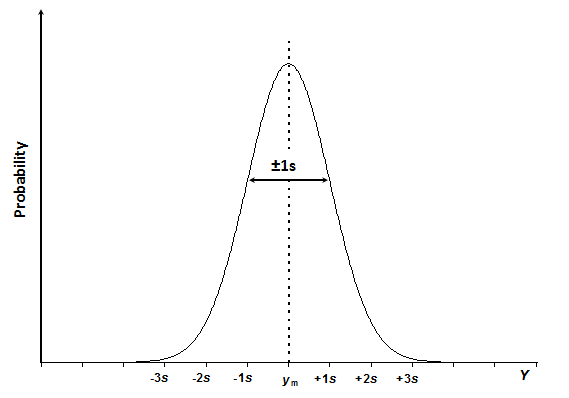

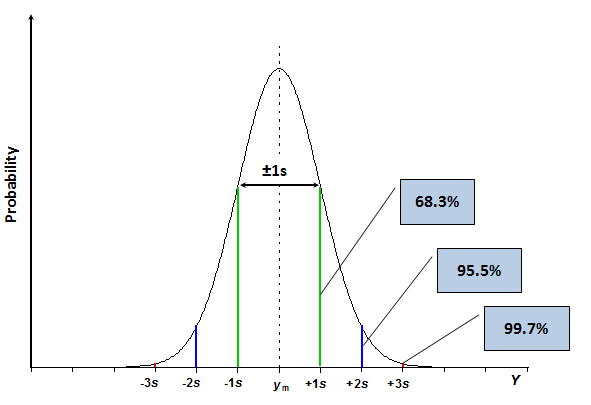

| From the point of view of mathematical statistics, our measured quantities are actually random quantities. And random quantities are described by distribution functions. And when we deal with measurement science, then the most important distribution function for us is the normal or the Gaussian distribution. And because of certain laws of nature, whenever a process or a result is influenced by many factors, then the more factors we have that influence, the nearer the distribution function of that result becomes to the normal distribution. Therefore, very often measurement results are distributed normally, and the large part of the mathematics that is used in measurement science is based on the properties of the normal distribution. The normal distribution function curve is depicted in this slide. It characterizes the probability of a random quantity, and the random quantity is Y in our case. And the probability is on the vertical axis. And this distribution function tells us that there's a certain most probable value, the mean value Yn, where the probability of this random quantity occurring is highest. And as we depart from the mean value to either of these two sides, the probability gradually decreases. So that this is basically a probability density graph; the highest probabilities in the middle, the lowest on the sides. There are some important properties of this distribution function. First of all, even though the probability gradually decreases and actually quite sharply decreases as we move away from the main value, it never really becomes a zero. So there will also always be some positive nonzero probability. And this is the main reason why usually we cannot give measurement uncertainties 100% probability that we saw in another lecture. This normal distribution function property actually tells us that this is impossible. Now the second important feature this normal distribution curve is that even though it never really ends. so there always will be positive value however far we move from the mean value. Nevertheless, the area, the area under this curve is finite, and in the case of normalized function, it's equal to unity. Meaning the probability of this value being somewhere is 100%, which obviously needs to be true. Now let us examine the normal distribution function work closely on the example of pipetting. So we have a 10 mL pipette and suppose we pipette several times, trying to pipette ten milliliters every time. What happens? What happens is that every time, we get a slightly different value. So, see, it's always somewhere near ten milliliters, but never exactly ten. And also, it tends to be quite different, different. If we now plot these values as a histogram, then, we see something like this. This histogram in principle should resemble the beautiful bell-shaped curve that we just saw. But we see that it is, in fact, very different. The reason is obvious: we have only made ten measurements up to now, and ten measurements is a too small number to get the normal distribution curve. Let us also look at this axis here, it's now not probability, but frequency. Probability and frequency are closely connected to each other. Basically, the higher the probability, the higher the frequency of a certain measurement result occurring within a certain volume. Let us examine now what happens if we make more measurements. So as the measurements come, we see that they tend to come into the center part more often than on the sides. We can see that if we now make 27 measurments, then even though we still don't have this nice bell-shaped curve we already now have more measurement results in the middle and less measurement results on the sides. So that the number of measurement is increasing and this distribution function depicted here by histogram becomes more normal distribution like. But if we now make many a very large number of measurements, let's say 1,000 then our histogram really will resemble the normal distribution very nice. It is not really easy to make 1,000 measurements whatever the measurement is. But luckily we do not need nearly as many measurements to get the important characteristics of the normal distribution. So usually we do not need to record this shape as such. We simply need to know some important characteristics or important parameters. And those most important characteristics of parameters are two. The mean value, which characterizes the position of this curve, and the standard deviation S which characterizes its width or the scatter of the results. So the smaller the standard deviation, the smaller the scatter of the results. And now, with the use of this curve, we can make some very important observations about its nature. So we can see that if we move from the mean value away by one standard deviation to either of the sides, then we get a contour of this shape. I turns out, from the properties of the normal distribution function, that the ratio of this area to the overall area under this normal distribution curve, is a roughly 68%. This is the basis of definition of standard uncertainty. So standard uncertainty, as we see in many cases in other lectures, is the uncertainty given at one standard deviation level and also it's there by uncertainty at roughly 68% probability. Now we can multiply this standard deviation by some factor and if we multiply it by two, then we get this kind of curve. And now the area of this part here as related to the whole area under the normal distribution curve makes up roughly ninety five point five percent. And this here forms the basis of the so called expanded uncertainty. So expanded uncertainty, as we can see in other lectures, is obtained by multiplying standard uncertainty with some coverage factor. Two in this case. And it allows us, enables us obtaining measurement uncertainty estimate with higher probability. So this 2's level or as we say expanded uncertainty at k2 level, is uncertainty at roughly 95,5% probability. So the probability of the true value falling within this range is now significantly high. And likewise, if we multiply S by 3 then the same percentage will be 99.7% | Du point de vue des statistiques mathématiques, les quantités que nous mesurons sont en fait des quantités aléatoires. Les quantités aléatoires sont décrites par des fonctions de distribution. Quand nous avons affaire à la science de la mesure, alors la fonction de distribution la plus importante pour nous est la loi normale ou la distribution Gaussienne. À cause de certaines lois naturelles, lorsqu'un procédé ou un résultat est influencé par plusieurs facteurs, alors, plus on a de facteurs qui ont une influence, plus la fonction de distribution du résultat tend vers une distribution normale. Par conséquent, les résultats de mesure sont très souvent distribués suivant la loi normale. La plupart des lois mathématiques qui sont utilisées dans la science de la mesure sont basées sur des propriétés de la distribution normale. La courbe de la fonction de distribution normale est illustrée dans cette diapositive. Elle caractérise la probabilité d'une quantité aléatoire, qui est dans notre cas Y. La probabilité est sur l'axe vertical. Cette fonction de distribution nous dit qu'il existe une certaine valeur, la plus probable, la valeur moyenne Yn, où la probabilité que cette quantité aléatoire se produise est maximale. À mesure que nous nous éloignons de la valeur moyenne de part et d'autre, la probabilité diminue progressivement. Il s'agit donc d'un graphique de densité de probabilité avec au milieu, les plus grandes probabilités et les plus faibles sur les côtés. Il existe des propriétés importantes de cette fonction de distribution. Premièrement, même si la probabilité diminue progressivement et plutôt rapidement en s'écartant de la valeur moyenne, elle n'est jamais égale à zéro. Donc il y aura toujours des valeurs de probabilités positives et non nulles. C'est la raison pour laquelle on ne peut pas donner des incertitudes de mesures avec une probabilité de 100% comme nous l'avons vu dans d'autres cours. Cette propriété de la fonction de distribution normale nous dit donc que cela est impossible. La deuxième caractéristique importante de cette courbe de distribution normale est que même si elle ne se termine jamais, il y a donc toujours une valeur positive peu importe à quel point on s'éloigne de la valeur moyenne. Toutefois, l'aire sous la courbe reste finie. Dans le cas de la fonction normale elle est égale à 1. Ce qui signifie que la probabilité de cette valeur d'être quelque part est de 100%, ce qui est, évidemment, un fait. Maintenant, examinons de plus près la fonction de distribution normale qui s'applique ici à l'exemple du pipettage. Nous avons donc une pipette de 10 mL et supposons que nous avons voulu pipetter plusieurs fois en essayant de pipetter 10mL à chaque fois. Que se passe-t-il ? Ce qui se passe, c'est qu'à chaque fois on a une valeur légèrement différente. Nous pouvons voir que c'est toujours autour de 10mL mais jamais exactement 10. Cela a tendance à être différent. Si maintenant, nous relevons les données et que nous en faisons un histogramme, nous observons quelque chose comme ça. Cet histogramme devrait en principe ressembler à la belle courbe en forme de cloche que l'on vient de voir. Mais on constate que c'est très différent. La raison est évidente, nous avons seulement fait 10 mesures jusqu'à maintenant et c'est un nombre trop petit pour avoir une courbe de distribution normale. Regardons aussi cet axe (vertical), il ne s'agit plus de probabilités mais de fréquences. Probabilités et fréquences sont étroitement connectées car plus la probabilité est grande, plus la fréquence d'une certaine mesure de volume est élevée. Intéressons nous maintenant à ce qu'il se produit lorsque nous effectuons plus de mesures. Au fil des mesures, les valeurs de volume tendent plus souvent vers la partie centrale que vers les côtés. Si nous réalisons à présent 27 mesures, même si nous n'obtenons toujours pas la courbe en cloche, nous avons quand même plus de mesures au centre que sur les côtés. Donc, le nombre de mesures augmente et la fonction de distribution décrite ici par l'histogramme se rapproche d'une distribution normale. Si nous faisons un nombre encore plus élevé de mesures, disons 1000, alors notre histogramme ressemblera vraiment à une distribution normale. Ce n'est pas vraiment simple de faire 1000 mesures, peu importe la mesure dont il s'agit. Heureusement, nous n'avons pas besoin d'autant de mesures pour constater les caractéristiques de la distribution normale. Habituellement, nous n'avons pas besoin d'obtenir cette courbe (gaussienne). Nous avons juste besoin de connaitre les caractéristiques importantes ou les paramètres importants. Ces derniers sont au nombre de deux. La valeur moyenne qui caractérise la position de cette courbe, et l'écart type, S ,qui caractérise sa largeur ou la dispersion des résultats. Plus l'écart type est petit, moins la dispersion est grande. Grâce à l'étude de cette courbe, nous pouvons effectuer des remarques très importantes à propos de sa nature. Si nous nous éloignons de la valeur moyenne d'une unité d'écart type, de part et d'autre, alors nous avons le contour d'une partie de la courbe. Et il s'avère qu'avec les propriétés de la distribution normale, le ratio de l'aire de cette forme par rapport à l'aire totale sous la courbe est d'environ 68 %. Ceci est la base de la défintion de l'incertitude type (u). Cette dernière, comme nous l'avons vu dans plusieurs cas dans d'autres cours, est l'incertitude donnée pour une unité d'écart type et est d'environ 68%. Nous pouvons multiplier l'écart type par des facteurs et si nous le mutliplions par deux alors nous obtenons ce type de courbe. Et maintenant, le ratio de l'aire de cette courbe par rapport à l'aire totale sous la courbe de distribution normale correspond à environ 95,5%. Et cela forme la base de ce que l'on appelle l'incertitude élargie (U). Cette dernière, comme indiqué dans d'autres cours, est obtenue en multipliant l'incertitude type avec avec des facteurs d'élargissement (k). Deux dans ce cas. Et cela nous permet d'obtenir l'incertitude de mesure obtenue avec le plus de probabilité. Ce niveau "2s" ou plutôt incertitude élargie à un niveau de facteur 2, est l'incertitude à environ 95,5% de probabilité. Donc, la probabilité que la valeur vraie tombe dans cet intervalle, est significativement élevée. Pareillement, si l'on multiplie S par 3, alors ce pourcentage sera de 99,7%. |

Toutes les quantités mesurées (mesurandes) sont du point de vue des statistiques mathématiques des quantités aléatoires. Les quantités aléatoires peuvent avoir différentes valeurs. Cela a été démontré dans la vidéo sur l'exemple du pipettage. Si le pipettage avec une même pipette de volume nominal 10 ml est répété plusieurs fois, tous les volumes de pipettage tournent autour de 10 ml, mais restent légèrement différents. Si un nombre suffisamment grand de mesures répétées est effectué et si les volumes [1] pipettés sont tracés en fonction de leur fréquence d'utilisation, il devient évident que bien que aléatoires, les valeurs restent régies par une relation sous-jacente entre le volume et la fréquence : la probabilité maximale d'un volume est comprise entre 10,005 et 10,007 ml et sa probabilité décroît progressivement vers des volumes de plus en plus grands. Cette relation s'appelle une fonction de distribution.

Les mathématiciens connaissent de nombreuses fonctions de distribution et la plupart d’entre elles se rencontrent dans la nature, c’est-à-dire qu’elles décrivent certains processus de la nature. En science de la mesure, la fonction de distribution la plus importante est la distribution normale (également appelée distribution gaussienne). Son importance découle du soi-disant théorème de la limite centrale. De manière simplifiée, les mesures peuvent être libellées comme suit : si un résultat de mesure est simultanément influencé par de nombreuses sources d’incertitude, si le nombre des sources d’incertitude approche de l’infini, la fonction de distribution du résultat de mesure se rapproche de la distribution normale, quel que soit le résultat et les fonctions de distribution des facteurs / paramètres décrivant les sources d'incertitude. En réalité, la fonction de distribution du résultat devient déjà impossible à distinguer de la distribution normale s'il existe 3 à 5 sources (en fonction de la situation) contribuant de manière significative à l'incertitude [2]. Cela explique pourquoi, dans de nombreux cas, les quantités mesurées ont une distribution normale et pourquoi l'essentiel de la base mathématique de la science de la mesure et de l'estimation de l'incertitude de mesure est basée sur la distribution normale.

Schéma 3.1. La courbe de distribution normale de la quantité Y avec la valeur moyenne ym et l'écart type s.

La courbe de distribution normale a l'aspect d'une cloche (schéma 3.1) et est exprimée par l'équation 3.1:

(3.1)

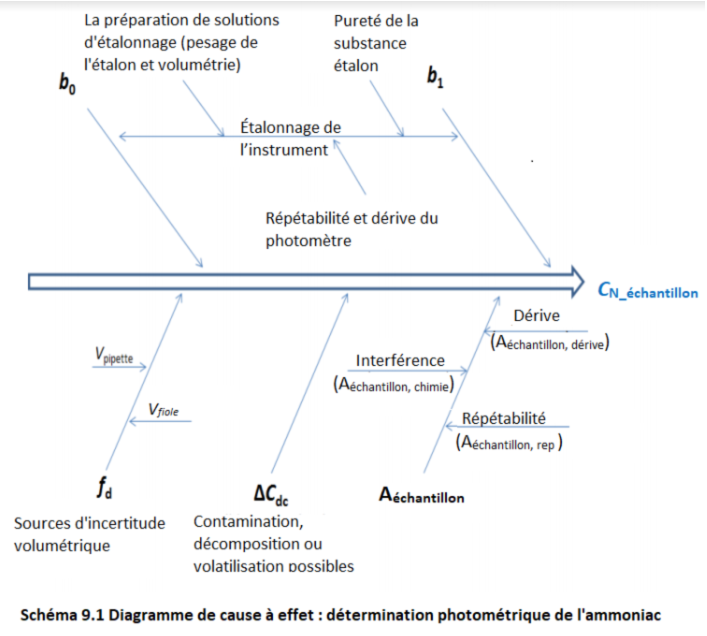

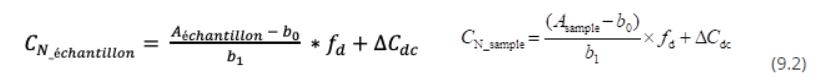

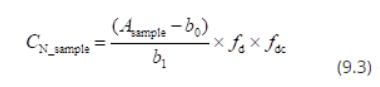

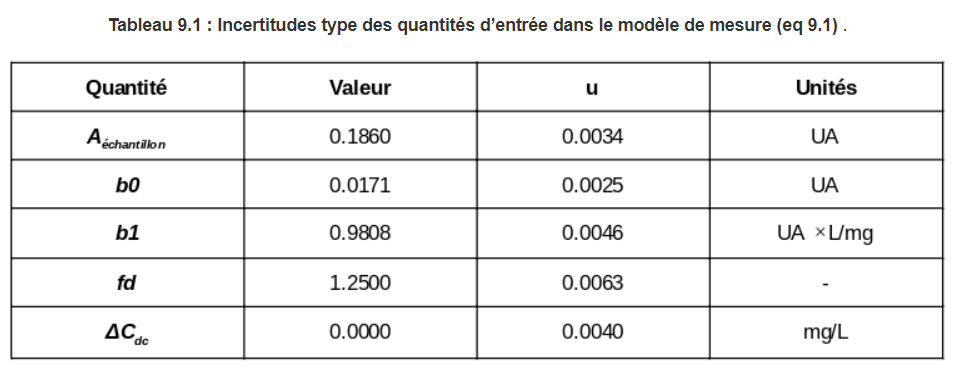

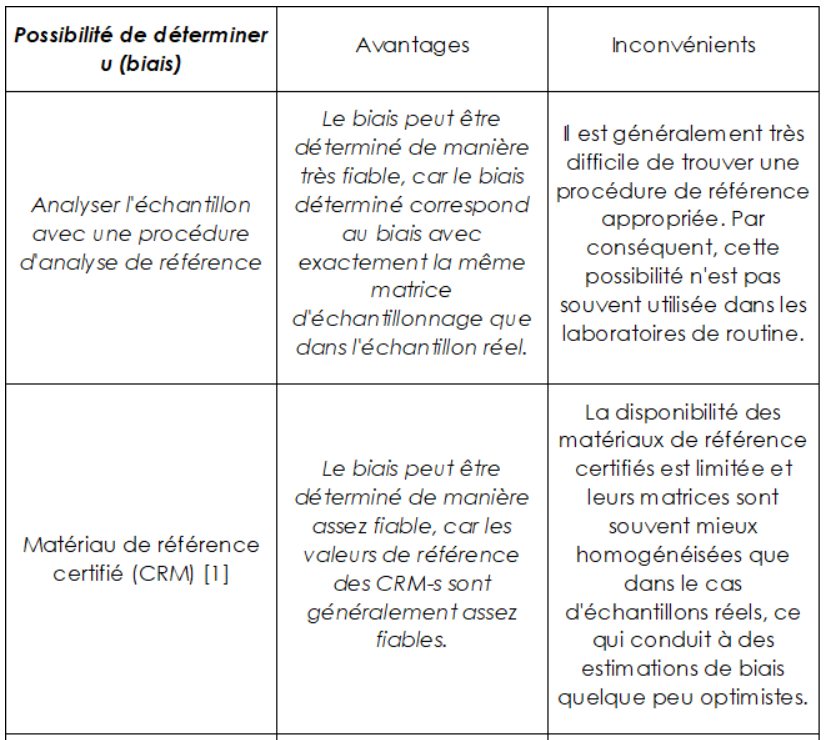

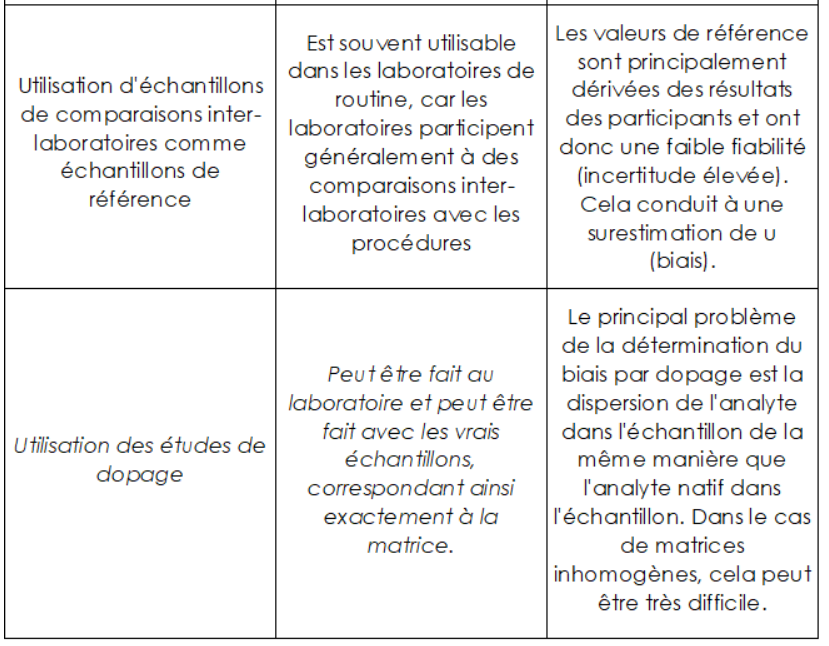

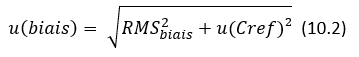

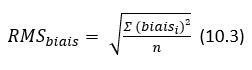

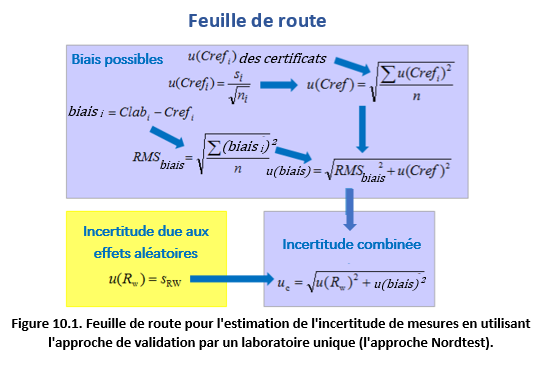

(3.1)